|스마트투데이=김나연 기자| 기업공개(IPO)를 앞두고 '중국 AI 택갈이' 의혹에 휩싸였던 업스테이지가 기술 개발 로그를 전면 공개하며 정면 돌파에 나섰다. 핵심 쟁점이었던 가중치 유사성은 통계적 착시임이 규명되었고, 백지상태에서 9조 개 토큰을 학습시켰다는 구체적 증거가 제시되면서 기술적 독자성 논란이 해소될지 주목된다.

2일 업스테이지는 ‘From Scratch로 학습한 Solar-Open-100B 공개 검증세션’을 열고 자사 AI 모델 솔라-오픈-100B(이하 솔라 오픈)의 개발 과정이 담긴 로그를 공개하고 제기된 의혹에 반박했다. 김성훈 업스테이지 대표는 "솔라 모델은 명백히 자체 개발(From Scratch)된 결과물"이라며 "수학적 데이터와 학습 기록이 이를 증명한다"고 밝혔다.

지난 1일 제기된 중국 즈푸AI 'GLM-4.5' 파인튜닝 의혹에 대해 업스테이지가 제시한 4대 핵심 반박을 정리했다.

① From Scratch(자체 개발)의 증거: WanDB 로그 공개

김 대표는 우선 업계에서 통용되는 자체 개발(From Scratch, 이하 프롬 스크래치)의 기준을 명확히 제시했다. LLM에서 ‘프롬 스크래치’란 가중치를 무작위로 초기화(Random Initialization)한 후 직접 학습시킨 경우를 뜻한다. AI 모델에서 가중치는 단순한 숫자가 아니라 방대한 데이터를 통해 깨우친 지식의 총체를 의미한다. 가중치가 무작위로 초기화된 상태는 뇌세포가 연결되지 않은 '갓 태어난 아기' 상태에서 교육을 시작하는 것과 같다.

이 때문에 타 모델의 가중치를 가져오는 순간 ‘프롬 스크래치’가 아닌 모델로 분류된다. 이미 학습을 마친 모델의 가중치를 가져오는 것은 대학 교육을 마친 성인의 뇌를 복사해 이식하는 격이기 때문이다. 타 모델의 가중치를 참고하여 자체 데이터로 추가 학습을 시킨 모델은 ‘파인튜닝’한 모델로 분류한다. 다만 학계의 표준 모델 구조나 인퍼런스 코드를 참조해도 ‘프롬 스크래치’로 분류한다.

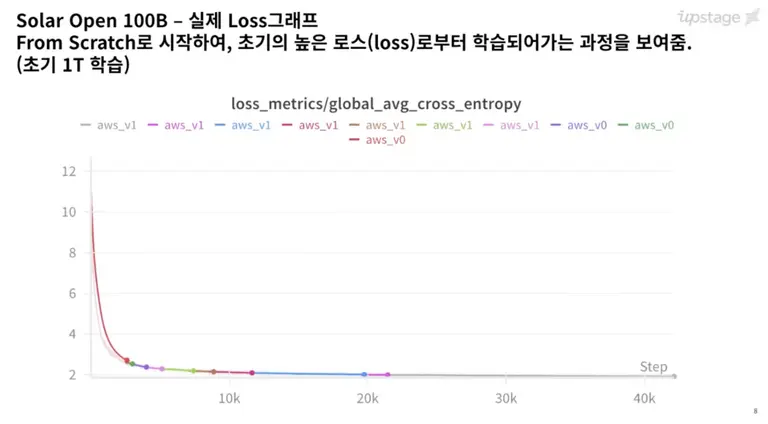

업스테이지는 이러한 기준에 맞춰 솔라 오픈 모델을 백지상태에서 직접 학습시켰다는 증거로 WanDB 로그를 제시했다. WanDB는 개발 과정을 실시간으로 기록하는 '블랙박스'다.

WanDB에 기록된 학습 곡선(Loss Curve)에 따르면, 솔라 오픈 모델은 학습 초기 에러율(Loss)이 급격히 치솟았다가 학습이 진행될수록 2.0 수준으로 수렴하는 모습을 보인다. 이는 무작위 상태에서 시작하는 자체 개발 모델의 전형적인 특징이다. 완성된 모델을 가져다 쓴 경우 통상적으로 초기부터 낮은 에러율을 보인다.

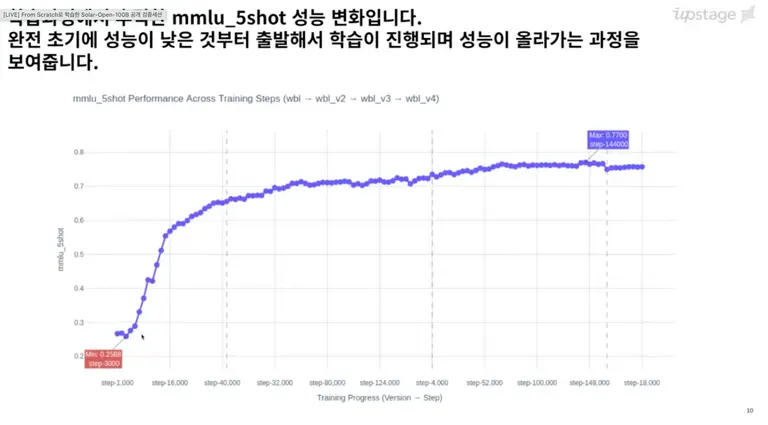

또한 총 9조(9T) 개의 데이터를 학습시키는 과정에서 모델의 지능 지표인 MMLU 점수가 0.25점(초기)에서 0.77점(최종)으로 우상향하는 데이터도 확인됐다. ‘아이’ 수준에서 ‘전문가’ 수준으로 지능이 상승하는 모습을 보인 것이다. 2025년 9월부터 기록된 체크포인트(중간 저장) 파일들 또한 실제 개발 타임라인을 반영하고 있었다.

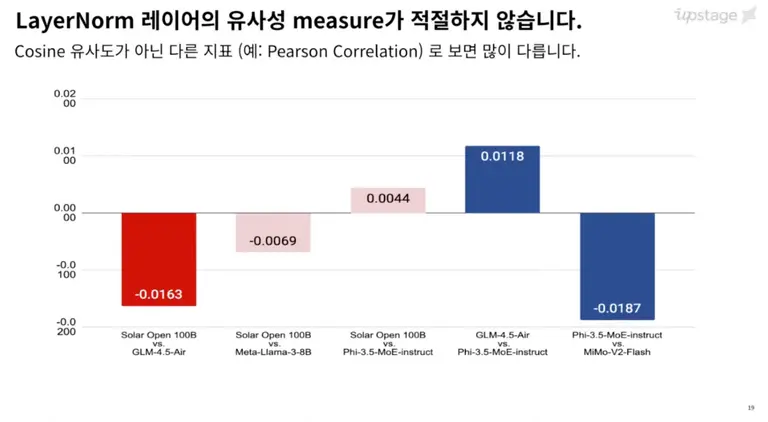

② 통계의 함정: "방향만 같을 뿐, 실제 지문(값)은 다르다"

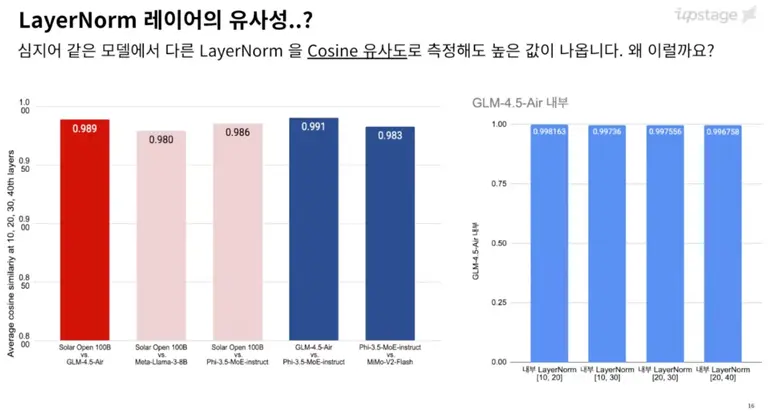

1일 제기된 의혹의 핵심 근거였던 '레이어 정규화(LayerNorm)' 수치 99% 유사성에 대해서 김 대표는 "지표 선택의 오류"라고 반박했다. 우선 논란이 된 파라미터는 전체 모델의 0.00004%(0.39M / 102B)에 불과하다. 김 대표는 “모델의 극히 일부분이 유사하다고 해서 동일한 모델이라고 간주할 수는 없다”고 설명했다.

뿐만 아니라 김 대표는 이 ‘극히 일부’마저도 의혹과 달리 유사성이 높지 않다고 강조했다. 의혹을 제기한 고석현 사이오닉 CEO가 사용한 코사인 유사도 지표가 벡터의 '방향'만을 측정한다는 점을 지적했다. 데이터 정규화 특성상 모델이 달라도 방향성은 99% 이상 유사하게 나오기 때문이다.

쉽게 설명하면, 코사인 유사도는 두 대상이 바라보는 방향이 얼마나 비슷한지를 보는 지표다. 키가 큰 사람과 작은 사람이 같은 별을 쳐다보고 있다면, 두 사람의 시선 각도(방향)는 거의 일치한다. 레이어 정규화는 데이터들을 일정한 범위로 모아주는 역할을 하므로, 어떤 모델이든 그 방향성은 99% 이상 비슷하게 나오게 되는 것이다.

실제로 솔라 오픈 모델은 문제가 된 ‘GLM-4.5’ 외에도 '메타-라마-3(0.980)'나 '파이-3.5(0.986)'와도 높은 유사도를 보인다.

김 대표는 코사인 유사도가 아닌 ‘피어슨 상관계수’를 사용해야 한다고 지적했다. 피어슨 상관계수는 실제 데이터 값의 분포가 얼마나 똑같은지를 따지는 지표다. 단순히 방향이 아니라 실제 데이터라는 '지문'이 일치하는지를 확인하는 더 정밀한 지표인 것이다.

솔라 오픈 모델과 GLM-4.5의 피어슨 상관계수를 분석한 결과는 음수(-0.0163)로 나타났다. 통계학적으로 0이나 음수는 상관관계가 없음을 뜻한다. 실제 가중치 값 전수 조사에서도 솔라(0.37, 0.33 등)와 GLM(0.92, 1.01 등)은 수치 자체가 완전히 다른 것으로 나타났다.

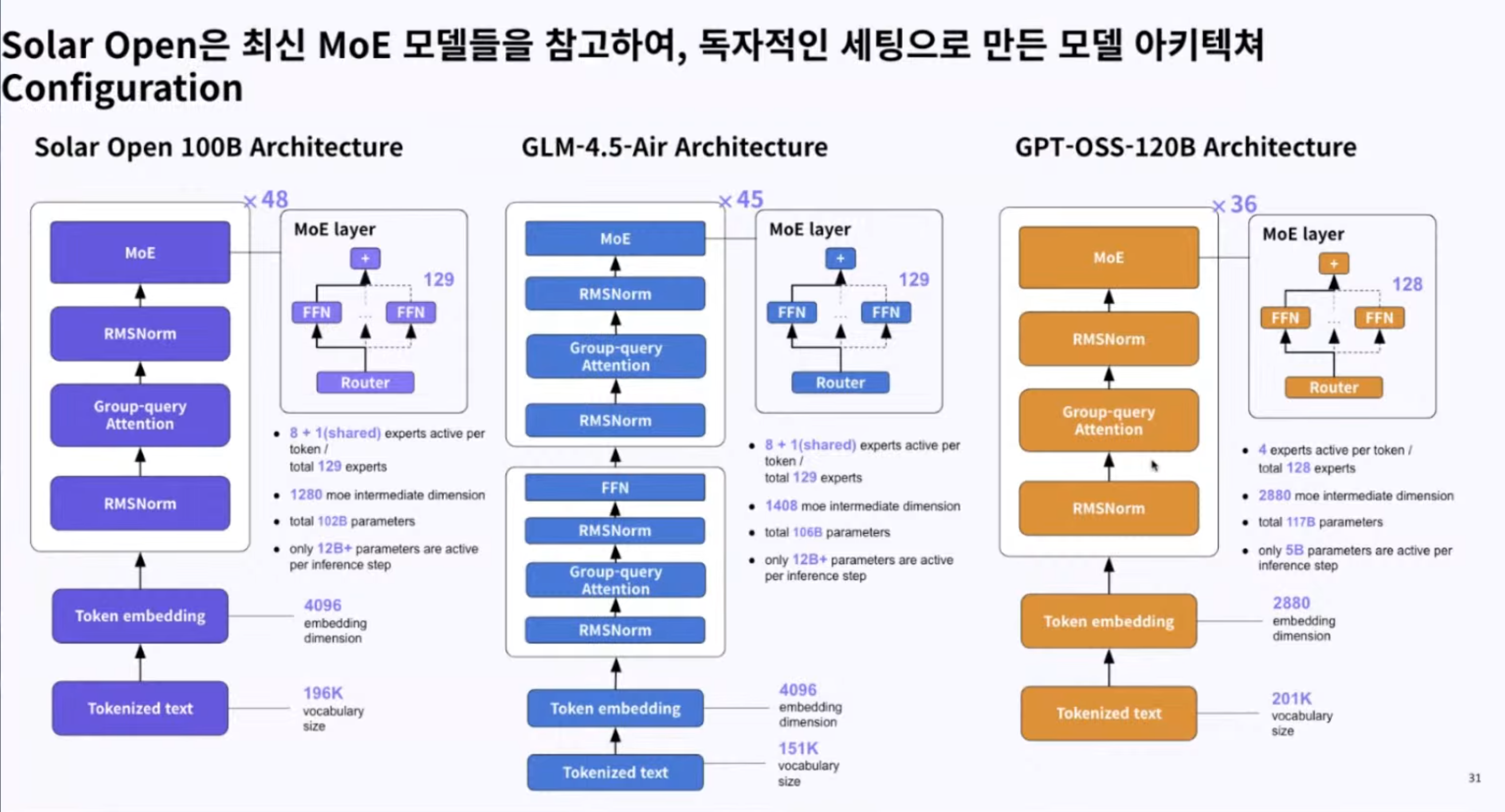

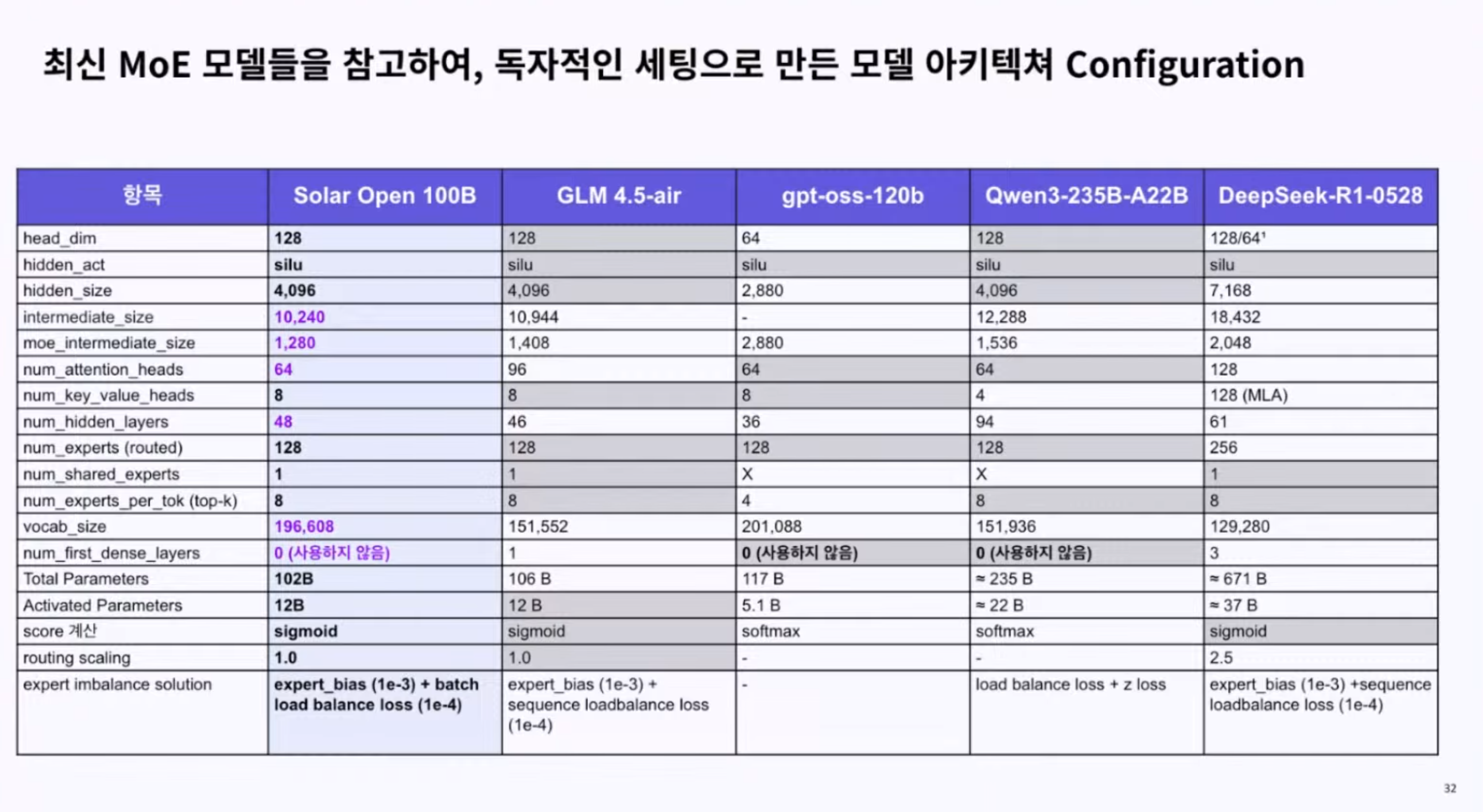

③ 뼈대가 다르다: "GPT-OSS 기반이지만 구조 뜯어고쳐"

김성훈 대표는 "통상적으로 모델 구조가 같고 가중치만 달라도 '자체 개발'로 볼 수 있지만, 솔라 오픈은 구조적 독창성까지 확보했다"고 강조했다. 김 대표는 "솔라는 'GPT-OSS'를 기반으로 하되, 상당 부분을 개량해 GPT-OSS와도 구조가 상이하며 가중치 또한 백지상태에서 학습시킨 모델"이라고 바로잡았다.

물리적 구조의 차이가 이를 뒷받침한다. 중국 즈푸AI의 GLM-4.5 모델에 존재하는 덴스 레이어(Dense Layer)가 솔라 오픈 모델에는 없다. 솔라 오픈에는 관련 설정값(first_k_dense_replace)도 0으로 처리됐다. 전체 레이어의 수 또한 솔라는 48층, GLM은 46층으로 다르다.

언어 처리의 핵심인 토크나이저(Tokenizer) 분석 결과도 완전히 달랐다. 솔라(196K)와 GLM(151K) 사이 겹치는 단어는 8만 개 수준으로, 중복 비율이 약 41%에 불과하다. 비슷한 토크나이저를 사용하는 모델들이 일반적으로 70% 이상의 중복률을 보이는 것과 대조적이다.

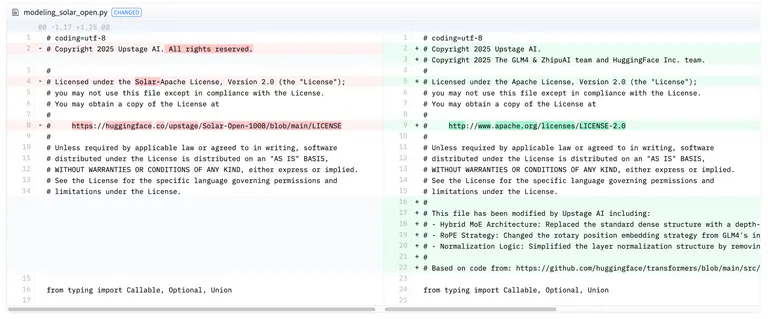

④ 코드가 비슷하다? "표준 플레이어 썼을 뿐"

소스코드 라이선스에 중국의 즈푸AI 팀을 명기한 것에 대해서는 "라이선스 변경에 따른 조치"라고 해명했다. 업스테이지는 모델 공개 이후 범용성을 위해 라이선스를 '아파치 라이선스 2.0'으로 변경했다. 아파치 라이선스란 누구나 소프트웨어를 자유롭게 수정하고 배포할 수 있게 허용하는 라이선스다. 아파치 라이선스는 '남의 코드를 가져다 썼으면 원작자의 이름을 반드시 표시하라(Attribution)'는 강제 조항을 포함하고 있다.

업스테이지가 즈푸AI를 명기한 것은 모델의 지능을 의미하는 ‘가중치’가 아닌 ‘코드’에 대한 라이선스 때문이다. 그중에서도 업스테이지가 참고한 것은 즈푸AI의 ‘인퍼런스 코드(inference code)’다. 인퍼런스 코드는 모델이 원활하게 작동하도록 돕는 구동 코드를 의미한다. 음악 파일(모델)을 재생하기 위해 대중적인 MP3 플레이어(인퍼런스 코드)를 쓰는 것이다.

업스테이지는 전 세계 개발자들이 주로 사용하는 구동 도구인 'vLLM'과의 호환성을 확보하기 위해 ‘허깅페이스’의 표준화된 인퍼런스 코드를 가져와 솔라 오픈 모델에 맞춰 변형했다. 이때 사용된 인퍼런스 코드의 원저작자가 즈푸AI 팀이었기 때문에 코드 라이선스에 명기했다는 것이다.

업계는 투명하게 데이터와 모델 구조를 공개한 것이 업스테이지의 기업 가치 방어에 긍정적 영향을 미칠 것으로 보고 있다.

한편 업스테이지는 의혹을 제기한 고석현 사이오닉AI CEO에 대해 법적 책임을 묻지 않겠다고 밝혔다. 김 대표는 “통계적 오류는 저를 포함해 누구나 저지를 수 있는 실수”라며 “업스테이지의 반박에 대해 수긍하는 모습을 보인다면 법적 책임을 물을 이유가 없다고 생각한다”고 밝혔다.

![[US New ETF] ②도지코인부터 UFO까지…상상력의 한계 깬 ETF 신대륙](https://cdn.www.smarttoday.co.kr/w400/q85/article-images/2026-02-13/8923e86f-a2a7-44d4-9fb0-a8f11699cda0.jpg)

![[key Player]](https://cdn.www.smarttoday.co.kr/w400/q85/article-images/2026-02-17/1dea056d-3c3d-441f-a4bd-4487a2e9a075.jpg)

![[US New ETF] ①](https://cdn.www.smarttoday.co.kr/w400/q85/article-images/2026-02-13/f9c25e8e-a00a-492f-a5a0-06c7cb1ba239.jpg)

![[케이뱅크 IPO] ⑧주가 내려야 BC카드 웃는다…하단 공모가로 FI 계약 '인버스화'](https://cdn.www.smarttoday.co.kr/w400/q85/article-images/2026-02-13/d062315d-eaf6-4423-868d-81f2e3f2e018.jpg)

댓글 (0)

댓글 작성